Référencement Google SEO – Les Bonnes pratiques

L’algorithme de recherche Google change fréquemment, très fréquemment. (quarante mise à jour rien que pour le mois de février 2012) ; les changements qui provoque une modification notoire des résultats dans les SERP’s sont baptisés sous le nom de campagne comme : “Google caffeine”, “Google maps”, “Google mobile”, “Google Panda”, “Google plus”, “Google semantique”, “Google pingouin”. Un blog dédié publie maintenant presque quotidiennement ces mises à jour : http://insidesearch.blogspot.com

Les principaux changement suivent 5 tendances :

- Aspect fraîcheur : on estime que 30% du trafic de recherche est impacté.

- Aspect local : Les recherches locales représentent désormais 13% du trafic global.

- Aspect mobile : 6,5% du trafic provient du Mobile

- Aspect social : des études embryonnaires ont révélé qu’une infime partie (0,5 à 1% en B2C) du trafic est concernée, on peut s‘attendre à au moins 10% dans l’avenir.

- Aspect sémantique : 10 à 20 % des requêtes seraient concernées. Google ne renverrait plus le trafic vers la source mais répondrait directement dans ses SERPs.

Pour résumer, c’est plus de 70% du trafic de recherche qui obéit à de nouvelles règles, et si on ajoute l’effet Panda qui porte sur plus de 12% des recherches faites au niveau anglophone, on va dépasser les 80%, autant dire que nous devons repenser les stratégies SEO !

Rappelez-vous la récente sortie de Matt Cuts où il déplore que trop de référenceurs SEO se concentrent sur la technique pas le contenu !!

“So if you’re a good SEO, someone who is paying attention to conversion and not just rankings on trophy phrases, then you might want to pay some attention to testing different meta descriptions that might result in more clickthrough and possibly more conversions.” Matt cuts – Google, Mars 2012. tweet

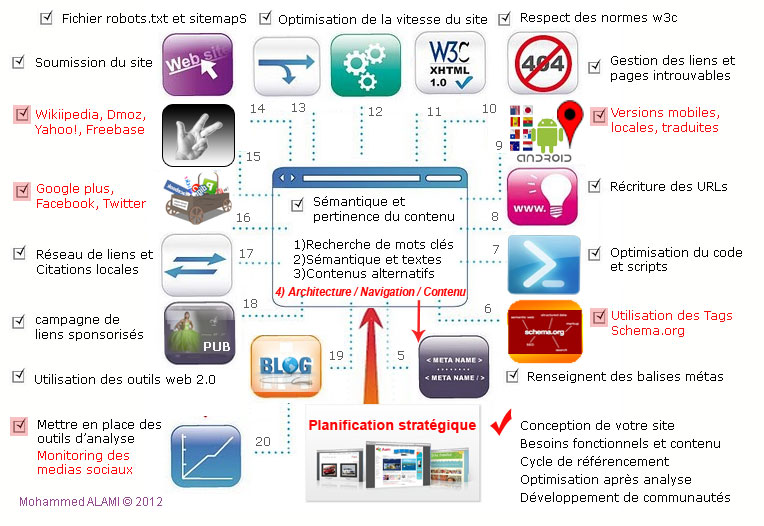

Aussi, nous allons donc énumérer les étapes en détaillant ce qui me semble plus important à développer :

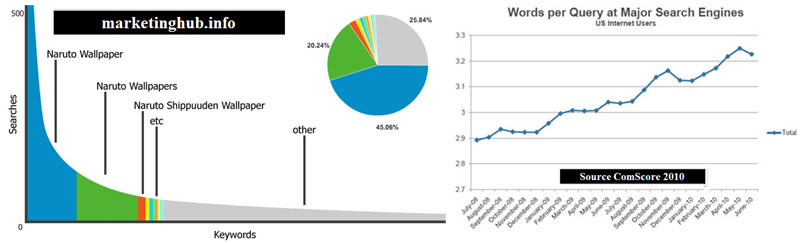

1. Recherche de mots clés : ici la stratégie à adopter est celle d’identifier ceux qui ont un potentiel de drainer du trafic en optant s’il le faut pour les mots clés de longue traine (long tail keywords).

2. Sémantique et pertinence du contenu : ayez en tête que Google interprète le contenu et extrait de l’information de données non structurées. Alors il est recommandé d’utiliser une sémantique claire et éviter les ambiguïtés.

3. Contenus alternatifs : il s’agit bien sûr des attributs « ALT » mais aussi des balises « Object » « Flash »… même dans une Iframe on peut placer une description. Le mieux est d’utiliser un outil comme Seobrowser.com pour voir le site comme un robot ou passer par les outils Google webmaster.

4. Expérience utilisateur – ici 3 aspects relatifs à l’expérience utilisateur mais aussi à la qualité du site au niveau de la conversion :

- Architecture : le but est double. Il faut permettre au moteur de crawler le site de haut en bas de manière naturelle via des textes de liens mais aussi de passer le « jus » de bas en haut pour que la Page d’accueil reçoive le maximum d’autorité.

- Navigation : ici le défi est de garder le visiteur sur site car un taux de rebond pour revenir vers les SERPs est un très mauvais signal envoyé à Google. On peut utiliser le fil de fer, la barre de recherche, articles similaires…

- Contenu : Gardons en tête les prévisions de Gartner notamment via sa fameuse « hype cycle » qui montre les attentes importantes en recherche vidéo

5. Renseignent des balises métas : bien que beaucoup déconseillent l’utilisation de la balise Keywords car elle n’est plus utilisée par les moteurs, je conseille toutefois d’y mettre le TOP 3 car certains annuaires s’en servent (comme DMOZ). Google vient de faire un point sur celles importantes (Description, Title, Robots, et Content-type). Puis ne négligez pas les balises Open graph car elles permettent de renseigner le titre, description, URL et image du contenu partagé sur les réseaux sociaux.

Google prend en charge les balises META suivantes (et les éléments associés) :

| <meta name=”description” content=”Une description de la page” /> | Cette balise fournit une brève description de la page. Dans certains cas, cette description est incluse dans l’extrait qui s’affiche avec les résultats de recherche.Plus d’informations |

| <title>Le titre de la page</title> | Bien que cette balise ne soit pas réellement une balise META, elle est souvent utilisée conjointement avec la “description”. Le contenu de cette balise est généralement affiché comme titre dans les résultats de recherche (et bien sûr dans le navigateur des internautes). Plus d’informations |

| <meta name=”robots” content=”…, …” /> <meta name=”googlebot” content=”…, …” /> | Ces balises META permettent de contrôler l’exploration et l’indexation effectuées par les moteurs de recherche. La balise META robots concerne tous les moteurs de recherche. En revanche, la balise META “googlebot” est spécifique à Google. Les valeurs par défaut sont “index, follow” (équivalent à “tous”) et il n’est donc pas nécessaire de les spécifier. Nous prenons en charge les valeurs suivantes (si vous insérez plusieurs valeurs, séparez-les par des virgules) :

Désormais, vous pouvez également spécifier ces informations dans l’en-tête de vos pages à l’aide de l’instruction d’en-tête HTTP “X-Robots-Tag”. Cette instruction est particulièrement utile pour limiter l’indexation de fichiers non HTML comme les images ou d’autres types de documents. En savoir plus sur le fichier robots.txt |

| <meta name=”google” content=”notranslate” /> | Lorsque le contenu d’une page n’est pas dans la langue choisie par l’utilisateur, nous fournissons généralement dans les résultats de recherche un lien permettant d’accéder à une traduction. Vous pourrez ainsi proposer votre contenu à une plus large gamme d’utilisateurs. Toutefois, cela peut ne pas être souhaitable dans certains cas. Avec cette balise Meta, vous interdisez à Google de fournir une traduction de votre page. |

| <meta name=”google-site-verification” content=”…” /> | Utilisez cette balise sur la page de plus haut niveau de votre site afin de confirmer que vous en êtes propriétaire dans le cadre des Outils pour les webmasters. Notez que les valeurs des attributs “name” et “content” (y compris majuscules et minuscules) doivent correspondre exactement à l’élément fourni. Cependant, vous pouvez remplacer la balise XHTML par HTML ou utiliser un format de balise adapté à votre page. Cela n’a aucune importance. En savoir plus |

| <meta http-equiv=”Content-Type” content=”…; charset=…” /> | Cette balise META définit le type de contenu de la page ainsi que le jeu de caractères. Veillez à insérer la valeur de l’attribut de contenu entre des guillemets droits. Dans le cas contraire, l’attribut charset pourrait être interprété de manière inappropriée. Plus d’informations |

| <meta http-equiv=”refresh” content=”…;url=…” /> | Cette balise META renvoie l’utilisateur vers une autre URL après un certain temps. Elle est parfois utilisée comme une simple redirection. Toutefois, elle n’est pas prise en charge par tous les navigateurs et peut induire en erreur les utilisateurs. Le W3C conseille de ne pas l’utiliser. Nous vous recommandons plutôt l’utilisation d’une redirection 301 côté serveur. |

Autres éléments à connaître :

- Google prend en charge les balises META de types HTML et XHTML, quel que soit le code utilisé sur la page.

- À l’exception de “verify”, vous n’avez pas besoin, d’une manière générale, de respecter la casse pour les balises META.

Cette liste de balises META n’est pas exhaustive. N’hésitez pas à insérer des balises META non répertoriées ici pour les besoins de votre site. Sachez simplement que Google ignorera les balises qu’il ne reconnaît pas.

6. Utilisation des Tags de Schema.org : il n’y a pas de règle unique. On sait maintenant que le futur du web est sémantiqueet que les tags mis à notre disposition par les moteurs permettent une meilleure compréhension et souvent un affichage plus attrayant des résultats (rich snipet). Mes préférés restent les tags entreprise, personnes et avis, produits et reviews qui influent directement sur le positionnement.

Une utilisation extraordinaire en référencement reste le balisage du catalogue produit pour échange standard avec partenaires et revendeurs, d’où la possibilité de drainer l’autorité et garder la main sur la source officielle (certaines marques se font devancer par leurs affiliés !). Et puis mentionnons quand même que le gain en trafic naturel de Best Buy de l’ordre de 30%, après avoir implanté la solution Good Relations est vraiment motivant.

7. Optimisation du code et scripts : j’avais déjà couvert cet aspect sauf que maintenant c’est plus clair avec la prise en compte de la vitesse du site pour le classement et aussi la portabilité des données sur les différentes plateformes.

8. Récriture des URLs : ici je voudrais simplement apporter une précision. En effet une url genre “mon domain.com/exemple n’est pas considérée idem pour www.mondomaine.com/exemple/. Autant fermer donc les URLs.

9. Versions site mobile, local et traduites : Google est clair à ce sujet en considérant le fait d’avoir le même contenu servi avec différents rendus selon le navigateur ou l’interface, n’est pas du cloacking. Je conseille toutefois de rajouter une balise « canonical » pour indiquer l’URL à indexer en cas de duplication. De plus, Google vient de publier un nouvel attribut pour les sites multilingues qui peut l’aider à y voir clair entre les différentes versions (hreflang=”x”). Dans ce chapitre, pour la géolocalisation, un test a révélé que l’utilisation de sous-domaine + répertoire était le mieux adapté. En effet, j’utiliserais le sous-domaine pour la localisation et le répertoire pour la langue et cette solution offre le confort de combiner les deux. Pour l’aspect mobilité. la récente sortie de Duanne Forester de Bing montre qu’un simple répertoire genre www.votresite.com/mobile est plus adapté : Optimisation de sites pour toutes les plateformes. Rappelez-vous Google considère désormais les sous-domaines comme des répertoires, alors autant utiliser une structure d’URLs qui colle à l’architecture du site.

10 . Gestion des liens et pages introuvables : j’ai été étonné de voir sur un guideline de Google sur le déplacement de sites qui fait mention de l’utilisation de XENU. Alors je ne peux que vous le recommander doublement puisque j’en suis fan.

11. Respect des normes W3C : bien que ce point ne fût pas confirmé dans les différentes études de facteurs de référencement comme SEOMOZ, il est recommandé de le passer avec succès car cela garantit une compatibilité avec les navigateurs et ça permet un affichage plus rapide.

12. Optimisation de la vitesse du site : aujourd’hui nous avons une pléthore d’outils.

13. Fichier robots.txt et envoi des sitemap : en plus du traditionnel sitemap, nous avons maintenant la possibilité de soumettre des plans de site pour les images et vidéos, et d’inclure l’adresse de ceux-ci dans le fichier robots.txt.

14. Soumission du site aux moteurs : il faut le faire une fois quand le site est nouveau.

15. Inscription dans les TOP5 : il devient presque obligatoire d’avoir un article sur Wikipedia (ou à défaut un lien externe ou de référence ou image), une entrée gratuite sur DMOZ et puis une belle fiche sur Freebase le nouveau chouchou de Google. Si vous avez le budget, complétez votre travail avec une inscription sur l’annuaire Yahoo! voir en plus Botw (mieux que les liens payants).

16. Création de pages de profil : Les tops 3 que sont Facebook, Twitter et Google plus vous donneront déjà une première visibilité en médias sociaux. En effet, par la simple création de pages de profils sur ces réseaux, vous obtenez des liens en Dofollow de Google et Twitter (ce qui n’est pas négligeable) et une mention sur Facbook. Maintenant, il faut garder en tête que les discussions donnent plus de sens aux résultats de recherche et donc il faut plutôt engager la conversation que de se contenter d’une présence passive.

17. Développement de réseau de liens : là on est dans une zone grise avec la dévaluation récemment annoncée par Google. Toutefois je suis persuadé qu’il vaut mieux en avoir trop que pas assez (la qualité prime sur la quantité toutefois). Il faut varier entre les liens faciles (annuaires, communiqués de presse et articles marketing) et ceux plus précieux provenant de sites d’autorité. En effet, si pour les premiers, des techniques existent pour le faire presqu’en automatique avec du spinning à la limite du black hat SEO, pour les derniers, il faudra faire de l’espionnage sur les compétiteurs et entrer en contact avec les Webmasters. Entre les deux, il y a tous les Digg like et réseaux sociaux. Dans tous les cas, à mon avis c’est là qu’un logiciel SEO trouve sa justification (Majestic SEO, SEOMOZ ou encore Linkdex).

Maintenant, dans la news dédiée aux facteurs SEO référencement local, j’avais souligné le manque de compagnies qui ont une politique de récolte de citations (seulement 19%) et donc il y a là une opportunité. Pour maximiser votre optimisation dans ce contexte, une récente étude qui revêt un aspect académique vient d’être initiée par BIZIBLE que je vous suggère de suivre, bien que de mon point de vue, David MIHM est déjà rendu expert dans ce domaine.

18. Lancement d’une campagne de liens sponsorisés : le dernier rapport publié par Google sur l’influence directe du référencement payant sur le trafic de recherche va dans le sens de ce que j’ai toujours prôné. Le but est double : créer de la visibilité mais aussi vérifier les mots clés et la pertinence du contenu. Même si Google et Bing réfutent que l’achat de liens sponsorisé booste le SEO, je reste persuadé du contraire. Dans un post publié par PULLSEO, qui analyse les synergies entre les liens sponsorisés Adwords et le référencement naturel sur Google, il apparaît clairement que les deux sont reliés. Considérez également une plateforme sociale pour valider votre ligne éditoriale des médias sociaux. Twitter vient d’annoncer la possibilité de viser les mobiles, ce qui à mon sens peut être pertinent pour dégager les tendances des sujets en temps réel.

19. Utilisation des outils web 2.0 : Au-delà des trois majors Facebook, Twitter et Google, en plus de Linkedin pour le domaine professionnel, les champions des médias sociaux en apport de trafic sont incontestablement StumbleUppon (voir Tumblr) et Youtube, suivis de Reddit et Digg. Je dois avouer que j’ai un coup de cœur pour ce dernier qui me permet d’indexer mon contenu presqu’en temps réel grâce à la promotion sur Google, et puis Youtube nécessite des moyens humains et matériels. Dans tous les cas, il vous faudra du contenu frais à partager et micro distiller, c’est pourquoi je conseille vivement l’utilisation de blog à cet effet.

Récemment, nous assistons à la montée en flèche de Pinterest au Canada et de celui de Scoop.it en France. Je vous renvoie à votre stratège médias sociaux pour établir vos priorités et identifier les places que votre niche fréquente

20. Mettre en place des outils d’analyse de trafic et monitoring des médias sociaux : Google a décidé de nous priver des mots clés cachés quand il s’agit de recherches via connexion sécurisée et cela concerne presque 30% du trafic naturel (même si Avinash Kaushik nous a donné quelques tuyaux). Je considère alors les rapports sur les requêtes de recherche disponibles via Google Webmaster Tools ou dans Google analytics (quand couplé avec GWT) sont très pertinents pour juger de l’avancement du référencement SEO. Du côté social, si en 2010 je me posais des questions concernant l’utilisation des outils de mesure d’e-réputation (engagement, analyse de sentiment, Net Promoter Score NPS), je me simplifie la vie en utilisant les segments avancés pour les réseaux sociaux sur Google Analytics et aussi en suivant les partages effectués via la plateforme Sharethis après avoir installé le bouton, et aussi des fois pour des besoins ponctuels, je peux utiliser Bit.ly ou Goo.gl qui tous les deux offrent une visibilité suffisante de la vie de l’URL partagée, à condition de la garder intacte. Notez qu’aujourd’hui Google vient d’annoncer le lancement de sa section valeur des médias sociaux dans Google Analytics.

Voilà, donc vous avez compris que ce n’est pas fini, avec ce travail d’analyse amorcé, nous allons identifier les succès rapides (quick wins) pour communiquer dessus et motiver les parties prenantes, et aussi prendre note des ratés et corriger le tir dans un nouveau cycle en ajustant les mots clés, le contenu, le message…etc.

By Mohammed Alami : http://www.mozalami.com